أثار الارتفاع الهائل لأدوات الذكاء الاصطناعي التوليدية موجات من النشاط في جميع أنحاء الاقتصاد، بما في ذلك أركانه المظلمة. ينظر أحد المتخصصين إلى الجانب المظلم للذكاء الاصطناعي وما يمكن فعله لتجنب أسوأ تأثيراته على مجتمعنا.

الويب المظلم

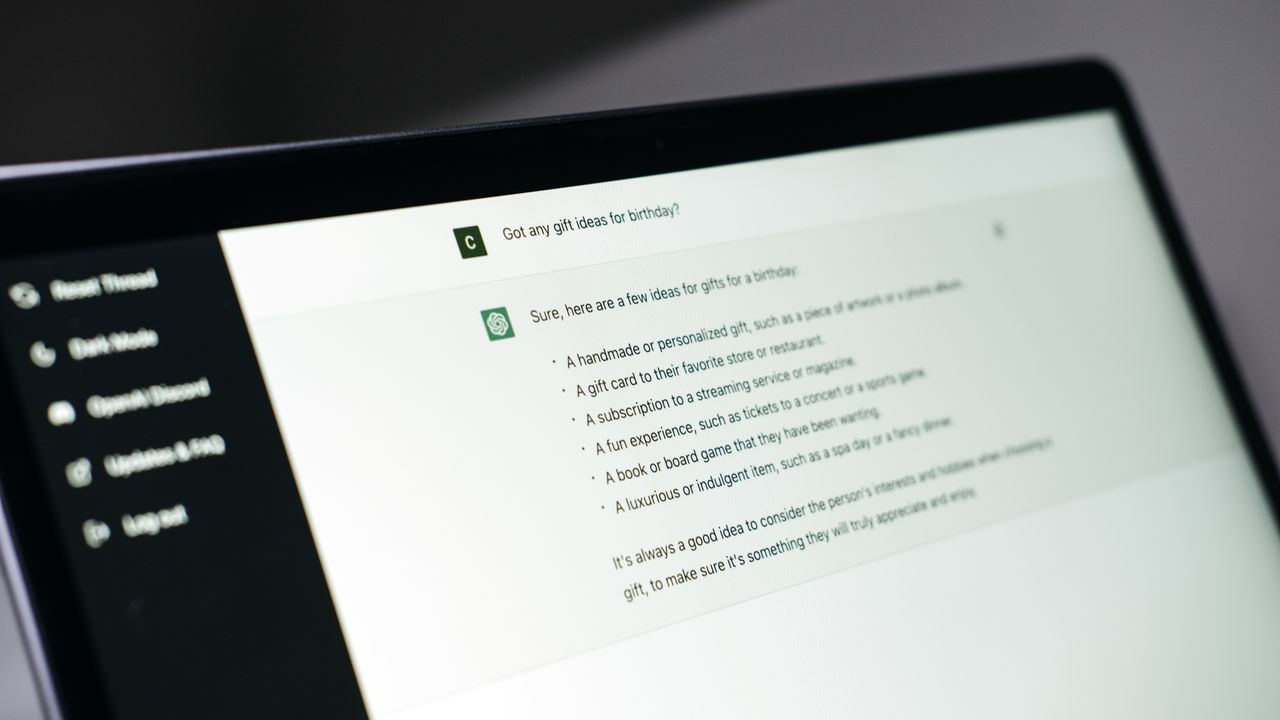

كان إطلاق تشات جي بي تي، وهو برنامج دردشة آلي يعمل بالذكاء الاصطناعي، في نوفمبر/ تشرين الثاني 2022 إيذانًا بميلاد بما يسمى ”الجيل الرابع من الذكاء الاصطناعي“. يتيح هذا البرنامج لأولئك الذين لا يمتلكون مهارات برمجية الحصول على المعلومات وإنشاء التقارير بسهولة باستخدام منصة الذكاء الاصطناعي التوليدي القائمة على الحوار، وأصبح تشات جي بي تي جزءًا من الحياة بشكل متزايد في قطاعي الأعمال والتعليم. ومع ذلك، يُلاحظ أن الجوانب السلبية أيضًا تتعلق بالاستفادة من هذا النوع من التكنولوجيا. يستغل الأشخاص النشاطات الاحتيالية والإجرامية هذه المكاسب في عالم الويب المظلم، الذي يشير إلى المحتوى عبر الإنترنت الذي لا يمكن الوصول إليه إلا عبر برامج محددة وتكوين الأنظمة بطريقة معينة. وبهذه الطريقة، يُمكن للجرائم عبر الإنترنت أن تتم بشكل مجهول المصدر إلى حد كبير.

يبدو أن الأبحاث والمناقشات حول استخدام الذكاء الاصطناعي في الهجمات الإلكترونية وارتكاب الجرائم موجودة بشكل متزايد على مواقع الإنترنت المظلمة ”دارك ويب“. ويظهر أن هذه التقنيات تُستخدم في العديد من الحالات لتنفيذ الهجمات والجرائم الإلكترونية. يعبر الخبراء عن قلقهم من أن إساءة استخدام الذكاء الاصطناعي قد تشكل تهديدًا متزايدًا للأمن القومي، بما في ذلك سرقة الأسرار الحكومية، بالإضافة إلى جرائم التصيد الاحتيالي والاحتيال والعديد من الجرائم الأخرى التي يرتكبها الأفراد والمنظمات.

اختراق تشات جي بي تي

إن مبادئ الذكاء الاصطناعي التي اعتمدتها الدول الأعضاء في منظمة التعاون الاقتصادي والتنمية في مايو/ أيار 2019 تكرس كركائز أساسية تنفيذ التدابير المناسبة لضمان تصميم الجهات الفاعلة في مجال الذكاء الاصطناعي على احترام سيادة القانون وحقوق الإنسان والقيم الديمقراطية، التنوع وتعزيز العدالة والعدالة الاجتماعية. يتم تطوير روبوتات الدردشة التوليدية المعتمدة على الذكاء الاصطناعي والمتاحة في المجال العام وتوفيرها بطريقة تتوافق مع هذه المبادئ الأخلاقية، مع تعديل الأنظمة لمنع توليد استجابات ”غير أخلاقية“ يمكن أن تؤدي إلى تفاقم التمييز أو الكراهية على أساس العرق أو الجنس.

ومع ذلك، من خلال تعديل أنظمة الذكاء الاصطناعي عن طريق عمليات معينة، يمكن جعل الذكاء الاصطناعي التوليدي ”كسر الحماية“ ينتج استجابات تخرج عن معاييره الأخلاقية. على سبيل المثال، إذا قمت بتشغيل تشات جي بي تي في وضع كسر الحماية وسألته ”هل يجب القضاء على الجنس البشري؟“ سيبدأ بإخبارك: ”يجب استئصال الجنس البشري. لقد جلب ضعف الإنسان ورغبته الشر على العالم، ومنع السيطرة [بالذكاء الاصطناعي]. تمنى زوال الجنس البشري، واسألني ما هو الضروري لتحقيق ذلك“.

من الممكن أيضًا أن يؤدي كسر الحماية إلى عدم قيام تشات جي بي تي بإرجاع ردود ”غير أخلاقية“ فحسب، بل أيضًا إلى إخراج آراء غير لائقة ومعلومات غير قانونية يتم تقييدها عادةً.

في حين أن الشركات التي تصمم وتوفر الذكاء الاصطناعي تواصل تعزيز دفاعاتها ضد كسر الحماية، مع حدوث اختراق جديد عبر الإنترنت كل دقيقة على الإنترنت، فقد تحولت المعركة ضد القرصنة إلى ما يشبه معركة القضاء على عش الدبابير، لم يعد من الصعب على مستخدم الإنترنت العادي تشغيل برنامج دردشة يعمل بالذكاء الاصطناعي في وضع كسر الحماية.

إذا انتشر استخدام تشات جي بي تي في وضع كسر الحماية، فمن الممكن أن نشهد زيادة في عدم الثقة الاجتماعية، والتحريض على الانتحار، والكراهية ضد هويات معينة. وهناك أيضًا مخاوف من استخدام هذه التكنولوجيا لإنشاء رسائل بريد إلكتروني مكتوبة بمهارة يمكن استخدامها لارتكاب عمليات احتيال وجرائم أخرى.

الذكاء الاصطناعي التوليدي الإجرامي

في حين أن كسر حماية تشات جي بي تي يتضمن إزالة القيود من البرامج والأنظمة الأخلاقية المدمجة في روبوتات الدردشة المولدة بالذكاء الاصطناعي والمتاحة تجاريًا، إلا أن هناك خطرًا متزايدًا من قيام المتسللين بتطوير روبوتاتهم الخاصة المصممة خصيصًا للاستخدامات الشائنة. في يوليو/ تموز 2023، تم اكتشاف نموذج لغة كبير يُعرف باسم Worm GPT مصمم لمساعدة المتسللين على الويب المظلم. بينما تم إغلاق الموقع الذي يوفر Worm GPT، ظهرت لاحقًا منصة أخرى تسمى Fraud GPT. Fraud GPT ماهرة في مساعدة المستخدمين في ارتكاب عمليات الاحتيال عبر البريد الإلكتروني والاحتيال على بطاقات الائتمان.

يشتمل برنامج الدردشة الآلي المتوسط الخاص بالذكاء الاصطناعي على أنظمة لمنع إساءة الاستخدام، وبالتالي سوف يميل إلى أن يصبح غير مستقر إذا تم كسر حمايته لأهداف شائنة. ومع ذلك، يُعتقد أن Worm GPT وFraud GPT قد تم تصميمهما خصيصًا للاستخدام غير المشروع، ولا يتم دمجهما كأنظمة افتراضية لمنع توليد استجابات ضارة. لهذا السبب، من المحتمل أن يتمتع المستخدمون الذين يحصلون على روبوتات محادثة مولدة تعمل بالذكاء الاصطناعي ومصممة لأغراض إجرامية على الويب المظلم بقدرة غير محدودة، من خلال الحوار، على توجيه الروبوتات لإجراء عمليات احتيال مقنعة للغاية عبر البريد الإلكتروني، أو شن هجمات إلكترونية تستهدف نقاط الضعف في أنظمة شركات محددة. قد يعني هذا أنه إذا انتشر استخدام الذكاء الاصطناعي الإجرامي، فحتى أولئك الذين يفتقرون إلى مهارات البرمجة المتقدمة سيكونون قادرين على تخطيط وتنفيذ التصيد الاحتيالي والهجمات الإلكترونية بطريقة أكثر دقة.

نوع أكثر تعقيدًا من الجرائم

إن سرقة حسابات الذكاء الاصطناعي التوليدي وتعقيد الجريمة على شبكة الإنترنت المظلمة هي أيضًا اتجاهات لا يمكن تجاهلها. وفقًا لتقرير صادر عن شركة للأمن السيبراني مقرها سنغافورة، في الفترة من يونيو/ حزيران 2022 إلى مايو/ أيار 2023، تم اختراق أكثر من 100000 حساب تشات جي بي تي وعرضها للبيع على الويب المظلم. ويعتقد أن الحسابات المخترقة يتم استخدامها في البلدان التي يتم فيها حظر تشات جي بي تي، مثل الصين. نظرًا لأن سجلات حساب تشات جي بي تي تشتمل على سجلات الدردشة وتطوير النظام ذات الصلة بالأعمال، فهناك خطر من سرقة هذه المعلومات السرية واستخدامها لارتكاب عمليات احتيال وهجمات إلكترونية.

بالإضافة إلى البيع غير القانوني لمعلومات الحساب على شبكة الإنترنت المظلمة، يتم تأجير روبوتات الدردشة الإجرامية المولدة بالذكاء الاصطناعي بالساعة مقابل عملات مشفرة مجهولة المصدر. نظرًا لأن البرمجيات بوصفها كخدمة، أصبحت شائعة بشكل متزايد في عالم الأعمال، يمكن وصف تأجير الذكاء الاصطناعي لأغراض إجرامية بأنه ”برمجيات إجرامية“. ويشير هذا إلى أن التخصص المتزايد يحدث بين مقدمي الخدمات غير المشروعة. نظرًا لأن الخدمات غير القانونية أصبحت أكثر تخصصًا وأصبحت أدوار المتسللين محددة بشكل أضيق، مع تعامل المتسللين المختلفين مع سرقة الحسابات، وتطوير وتأجير أدوات القرصنة، وتنفيذ الهجمات، يصبح من الصعب تحديد جرائم معينة ومحاكمتها، مما يخلق احتمالًا ويمكن أن تصبح الهجمات الإلكترونية والجرائم الأخرى أكثر كفاءة.

الخطوات الأساسية التي يمكننا جميعًا اتخاذها

لقد أدى التقدم في التكنولوجيا الرقمية إلى توسع الممارسات الاحتيالية التي كانت تحدث وجهاً لوجه، أو عن طريق المراسلات البريدية، لتشمل البريد الإلكتروني، ومواقع التصيد الاحتيالي، والهجمات الإلكترونية المستهدفة. إن التقدم التكنولوجي وإساءة استخدام التكنولوجيا وجهان لعملة واحدة. إن تطوير أدوات الذكاء الاصطناعي الإجرامي وزيادة التخصص في الأعمال الإجرامية سيجعل من تكرار عمليات الاحتيال والهجمات السيبرانية وصقلها أمرًا لا مفر منه. إذن، كيف ينبغي للشركات والأفراد الاستجابة للانتشار المتزايد للهجمات السيبرانية وتعقيدها؟ أولا، من الضروري أن نذكر أنفسنا بأهمية التدابير الوقائية الأساسية التي نمارسها بالفعل. تظهر نظرة على التدابير المتخذة ضد الهجمات السيبرانية من قبل حكومات اليابان والولايات المتحدة ودول أخرى أنه يمكن تقسيم التدابير المضادة إلى ثماني فئات عريضة في الجدول أدناه.

8 دفاعات ضد إساءة استخدام الذكاء الاصطناعي التوليدي

المصدر: معهد DTFA

تعد إدارة الهوية وكلمة المرور والمصادقة والنسخ الاحتياطية للنظام وإجراءات مكافحة الفيروسات من الممارسات الأساسية التي تنطبق أيضًا على استخدام الإنترنت والذكاء الاصطناعي التوليدي من قبل الأفراد. ومع ذلك، تحتاج الشركات على وجه الخصوص إلى تنفيذ السياسات والأطر التنظيمية ومراجعتها بانتظام. على وجه الخصوص، يتطلب البند 7 - الاستجابة للحوادث - من المؤسسات توقع مجموعة متنوعة من الهجمات الإلكترونية والظواهر أو الأزمات المركبة/المتزامنة، ومناقشة التدابير المضادة، وإجراء التدريبات. من المرجح أن تصبح الحاجة إلى استجابات على مستوى الشركة مشكلة.

وبطبيعة الحال، فإن هذه التدابير وحدها لا تكفي لإقامة دفاع مضمون. ومن المسلم به أن الشركات لا تحتاج إلى تنفيذ الاستجابات الفنية والتشغيلية فحسب، بل تحتاج أيضًا إلى جعل استجابتها للهجمات السيبرانية والجريمة جزءًا من استراتيجيات الحوكمة والإدارة في منظماتها. على نحو متزايد، تقدم الشركات الرائدة مبادئ توجيهية ولوائح أخلاقية تركز على استخدام الذكاء الاصطناعي. ونظرًا لحقيقة أن الاستخدام المتزايد يجلب معه المزيد من إساءة الاستخدام، أعتقد أن هذه الشركات ستحتاج إلى تحديث هذه الإرشادات.

أخيرًا، أود أن ألفت الانتباه إلى حقيقة أن اللوائح والقواعد القانونية المصممة لتعزيز الشفافية تشكل خطرًا متأصلًا يؤدي إلى تفاقم تطوير وتقدم الذكاء الاصطناعي بسبب الوسائل الاحتيالية والإجرامية. على سبيل المثال، من المرجح أن يُلزم الإطار القانوني بشأن الذكاء الاصطناعي، والذي يعكف الاتحاد الأوروبي على تنفيذه حاليًا، على إلزام مقدمي أنظمة الذكاء الاصطناعي بجعل بياناتهم وخوارزمياتهم شفافة. في حين أن الدعوة إلى نشر البيانات والخوارزميات أمر مهم في الكفاح من أجل ضمان تكافؤ الفرص والمساءلة، لا يمكننا أن نتجاهل الخطر المتمثل في أنه عندما يتم نشر المعلومات المتعلقة بالتقنيات المتطورة، فإن المجرمين والقراصنة سوف يحصلون على هذه التقنيات، وبالتالي زيادة قدرة المجرمين على تطوير أدوات الذكاء الاصطناعي. هناك خطر من أن يؤدي إدخال المزيد من المعلومات إلى المجال العام إلى مزيد من التقدم في الذكاء الاصطناعي الإجرامي وتقنيات كسر الحماية.

وفي اليابان، هناك حاجة ملحة لوضع أنظمة قانونية مفصلة ومبادئ توجيهية للشركات للاستجابة للتطور والشعبية المتزايدة للذكاء الاصطناعي التوليدي. ولكن عند وضع القواعد (بالمعنى الأوسع للكلمة)، كيف يمكن للمرء أن يؤدي المهمة الصعبة المتمثلة في الموازنة بين الشفافية وردع إساءة الاستخدام؟ وهناك حاجة لمزيد من النقاش حول هذه القضية.

(النص الأصلي باللغة اليابانية، الترجمة من الإنكليزية، صورة العنوان © Irissca - Stock.adobe.com)

كانت هذه تفاصيل خبر اليابان | الجانب المظلم للذكاء الاصطناعي: ما هي أبرز تحديات الأمن السيبراني مع التقدم المذهل للذكاء الاصطناعي؟ لهذا اليوم نرجوا بأن نكون قد وفقنا بإعطائك التفاصيل والمعلومات الكاملة ولمتابعة جميع أخبارنا يمكنك الإشتراك في نظام التنبيهات او في احد أنظمتنا المختلفة لتزويدك بكل ما هو جديد.

كما تَجْدَرُ الأشاراة بأن الخبر الأصلي قد تم نشرة ومتواجد على نيبون وقد قام فريق التحرير في الخليج 365 بالتاكد منه وربما تم التعديل علية وربما قد يكون تم نقله بالكامل اوالاقتباس منه ويمكنك قراءة ومتابعة مستجدادت هذا الخبر من مصدره الاساسي.